O perceptron foi o primeiro modelo de rede neural de fato implementada como um algoritmo. O modelo hoje compreende a forma mais simples de uma rede neural, podendo ser utilizada para classificar padrões linearmente separáveis, ou seja, que podem ser separados por apenas um hiperplano, em um conjunto com classes binárias.

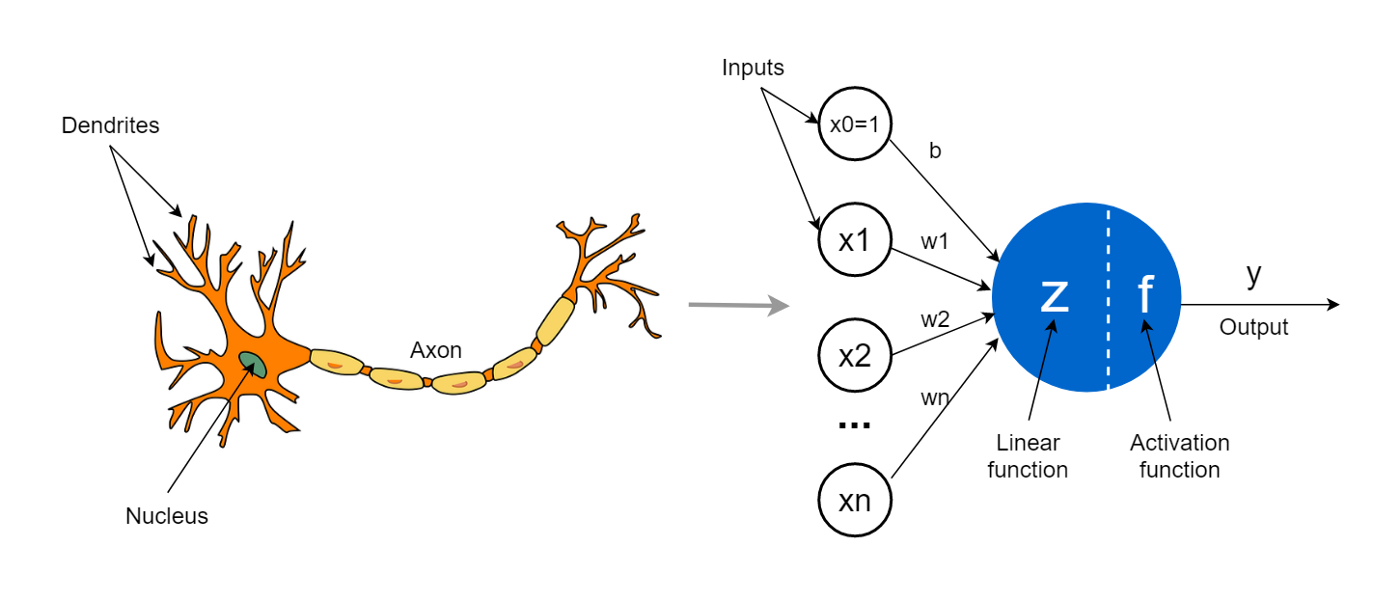

A rede consiste de um único neurônio com um vetor de pesos que pondera cada um dos atributos de entrada . Veja ainda que é adicionado um Viés às entradas, que pode ser representado por uma entrada ponderada por um fator .

No caso do perceptron, a função linear é a combinação linear das entradas ponderadas pelos pesos. O resultado dessa função é chamado potencial de ativação do neurônio, dado por:

O potencial de ativação é então usado como entrada para uma função de ativação, que tem o papel de normalizar o potencial de ativação. No caso do perceptron a função de ativação mais comum é a função :

Dessa forma, os resultados possíveis do neurônio são ou , sendo possível identificar apenas classes binárias.